Per completare il discorso sugli esperimenti e sulla significatività statistica iniziato sul primo numero di questa rubrica, complicando un po’ le cose, prenderemo a prestito due concetti che vengono dall’epidemiologia. Lo stesso argomento, da un punto di vista diverso, è già stato affrontato da Andrea Ferrero nella sua rubrica sul numero 4 di Query.

Supponiamo di avere organizzato un semplice test per mettere alla prova un sensitivo, che cercherà di prevedere se lanciando una moneta uscirà testa oppure croce in un certo numero di ripetizioni. Siamo ragionevolmente sicuri di aver preso sufficienti precauzioni per evitare trucchi e imbrogli (abbiamo controllato una per una le monete e le abbiamo conservate sotto chiave e sigilli in ceralacca fino al momento della prova, fatto in modo che le previsioni non possano essere alterate a posteriori usando qualche trucco da prestigiatore, controllato che sotto il tavolo non ci sia un calamitone per influenzare il moto della moneta, insomma messo in pratica tutto l’armamentario di accorgimenti che si insegnano nei corsi per investigatori del CICAP), quindi potremo valutare il successo o l’insuccesso sulla base della sola statistica.

Il P-value del test, se ricordate quanto raccontato nel primo numero di questa rubrica, è un numero che rappresenta la probabilità che il risultato trovato alla fine dell’esperimento sia dovuto al caso in assenza del fenomeno in esame; in altre parole, la probabilità che avrebbe un sensitivo sicuramente farlocco (senza alcun potere, ma che non usa trucchi) di ottenere un risultato analogo o migliore. Fissata una soglia arbitraria, diciamo all’1%, il sensitivo avrà superato il test se il P-value ottenuto sarà più basso di tale valore.

Nel caso dei test di questo tipo che il CICAP organizza, generalmente si cerca di minimizzare questa probabilità in modo da ridurre il rischio di ottenere un risultato “falso positivo” dovuto a una botta di fortuna del soggetto (in alcuni casi chiamato un “errore del primo tipo”).

C’è però un inghippo simmetrico: un veggente genuino, ma con un potere non sufficiente a farlo indovinare nella totalità dei casi, potrebbe non passare il test per pura sfortuna, generando un risultato “falso negativo” (anche detto “errore del secondo tipo”).

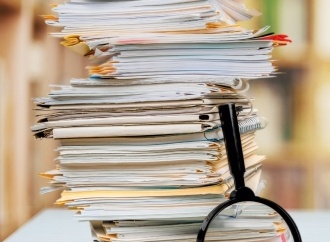

Possiamo riassumere i possibili risultati del test in una semplice tabellina:

Nella terminologia epidemiologica, la capacità di un test diagnostico di evitare i falsi positivi prende il nome di specificità, mentre quella di trovare i veri positivi (ossia evitare i falsi negativi) prende il nome di sensibilità. La prima è definita come la frazione di sani che danno un risultato negativo al test (cioè risulteranno effettivamente sani), la seconda come la frazione di malati che risulteranno positivi al test. Tradotto nell’ambito che ci interessa, questo vuol dire che la specificità del nostro test indicherà quanto bene rigetta i falsi veggenti, la sensibilità quanto è buono a trovare quelli veri. È chiaro che si deve cercare di evitare i falsi positivi, ma se vogliamo un esperimento onesto bisogna fare in modo che un eventuale sensitivo genuino abbia una ragionevole probabilità di passare il test.

E qui ci scontriamo con un problema. La specificità dipende solo da come è fatto l’esperimento: il numero di prove fatte (per esempio lanci della moneta) e la probabilità di successo in ciascuna prova (per esempio il 50%); anzi, di solito la decidiamo noi scegliendo il P-value. Se decidiamo un P-value dell’1%, per esempio, avremo l’1% di probabilità di avere un falso positivo. In maniera non troppo rigorosa, potremmo dire che il nostro test ha una specificità del 99%.

Invece per stimare la sensibilità, che si traduce nella probabilità di “mancare” un vero sensitivo, bisogna avere una stima delle dimensioni dell’effetto cercato, ossia nel nostro esempio quanto il vero veggente azzecchi la previsione più di uno che tiri a indovinare. Per vedere quanto questo può essere critico, facciamo un esempio realistico, risparmiando i calcoli che comunque non sono troppo complicati. Nell’esperimento di lancio descritto sopra, decidiamo di stabilire la soglia del P-value allo 0,1% (vogliamo essere molto sicuri) e fare 30 lanci. Per passare il test non è necessario che il veggente indovini ogni volta, ma ne deve azzeccare almeno 23 su 30: la probabilità di fare meglio per caso è appunto meno dello 0,1%. D’altra parte ci aspettiamo che in assenza di particolari poteri ne indovini circa 15.

Adesso immaginiamo che arrivi un vero sensitivo, che però ogni tanto sbaglia; diciamo che sbaglia nel 20% dei casi, mentre chi tira a indovinare ovviamente sbaglia nel 50%. Con i numeri che abbiamo deciso, il calcolo ci dice che il sensitivo ha quasi il 40% di probabilità di non passare il test, ossia una sensibilità solo del 60%! Per ridurre questa probabilità si può aumentare il numero dei lanci (con 100 lanci la sensibilità arriva al 97% circa, che potrebbe essere accettabile), oppure abbassare la soglia, però ovviamente aumentando il rischio di avere un falso positivo. Ancora peggio va con un sensitivo che indovini solo un po’ più del caso: se indovina nel 60% dei casi, per portare il rischio di un falso negativo sotto il 10% senza cambiare la soglia bisogna arrivare a 500 lanci.

Questo trade-off tra sensibilità e specificità è una caratteristica di moltissimi protocolli sperimentali, e non solo dei semplici esperimenti binomiali come questo. In alcuni casi si può usare la forza bruta e per esempio aumentare banalmente il numero delle ripetizioni, ma in altri questo non è possibile e si deve cercare un compromesso.

Ci sono due conclusioni che si possono trarre da queste considerazioni: in primo luogo che non è il caso di mettere soglie inutilmente alte, ma soprattutto che è necessario sapere alcune cose sul fenomeno che si vuole mettere alla prova. Il fatto che la sensibilità possa essere stimata solo avendo un’idea delle capacità del sensitivo (o più in generale delle caratteristiche del fenomeno in esame) è all’origine del fatto che il CICAP organizza quasi esclusivamente esperimenti di “verifica” in cui si mette alla prova una specifica affermazione. Per esempio, nel caso del test di un sensitivo l’unico a poter dire quanto si aspetta di indovinare è il soggetto stesso, che non deve solo dirlo ma sottoscriverlo nel protocollo che si concorda prima del test. Se dice, come spesso capita, «indovinerò nel 99% dei casi» il problema non si pone e si può stare tranquilli che la sensibilità sarà sufficientemente alta; se però il suo potere non è un gran che («indovinerò nel 60% dei casi») probabilmente dovremo organizzare un test più lungo e complicato di quello che avremmo progettato sulla base della sola necessità di evitare i falsi positivi.

Supponiamo di avere organizzato un semplice test per mettere alla prova un sensitivo, che cercherà di prevedere se lanciando una moneta uscirà testa oppure croce in un certo numero di ripetizioni. Siamo ragionevolmente sicuri di aver preso sufficienti precauzioni per evitare trucchi e imbrogli (abbiamo controllato una per una le monete e le abbiamo conservate sotto chiave e sigilli in ceralacca fino al momento della prova, fatto in modo che le previsioni non possano essere alterate a posteriori usando qualche trucco da prestigiatore, controllato che sotto il tavolo non ci sia un calamitone per influenzare il moto della moneta, insomma messo in pratica tutto l’armamentario di accorgimenti che si insegnano nei corsi per investigatori del CICAP), quindi potremo valutare il successo o l’insuccesso sulla base della sola statistica.

Il P-value del test, se ricordate quanto raccontato nel primo numero di questa rubrica, è un numero che rappresenta la probabilità che il risultato trovato alla fine dell’esperimento sia dovuto al caso in assenza del fenomeno in esame; in altre parole, la probabilità che avrebbe un sensitivo sicuramente farlocco (senza alcun potere, ma che non usa trucchi) di ottenere un risultato analogo o migliore. Fissata una soglia arbitraria, diciamo all’1%, il sensitivo avrà superato il test se il P-value ottenuto sarà più basso di tale valore.

Nel caso dei test di questo tipo che il CICAP organizza, generalmente si cerca di minimizzare questa probabilità in modo da ridurre il rischio di ottenere un risultato “falso positivo” dovuto a una botta di fortuna del soggetto (in alcuni casi chiamato un “errore del primo tipo”).

C’è però un inghippo simmetrico: un veggente genuino, ma con un potere non sufficiente a farlo indovinare nella totalità dei casi, potrebbe non passare il test per pura sfortuna, generando un risultato “falso negativo” (anche detto “errore del secondo tipo”).

Possiamo riassumere i possibili risultati del test in una semplice tabellina:

| Il fenomeno esiste | Il fenomeno non esiste | |

| Il test è passato | OK | Falso positivo |

| Il test non è passato | Falso negativo | OK |

Nella terminologia epidemiologica, la capacità di un test diagnostico di evitare i falsi positivi prende il nome di specificità, mentre quella di trovare i veri positivi (ossia evitare i falsi negativi) prende il nome di sensibilità. La prima è definita come la frazione di sani che danno un risultato negativo al test (cioè risulteranno effettivamente sani), la seconda come la frazione di malati che risulteranno positivi al test. Tradotto nell’ambito che ci interessa, questo vuol dire che la specificità del nostro test indicherà quanto bene rigetta i falsi veggenti, la sensibilità quanto è buono a trovare quelli veri. È chiaro che si deve cercare di evitare i falsi positivi, ma se vogliamo un esperimento onesto bisogna fare in modo che un eventuale sensitivo genuino abbia una ragionevole probabilità di passare il test.

E qui ci scontriamo con un problema. La specificità dipende solo da come è fatto l’esperimento: il numero di prove fatte (per esempio lanci della moneta) e la probabilità di successo in ciascuna prova (per esempio il 50%); anzi, di solito la decidiamo noi scegliendo il P-value. Se decidiamo un P-value dell’1%, per esempio, avremo l’1% di probabilità di avere un falso positivo. In maniera non troppo rigorosa, potremmo dire che il nostro test ha una specificità del 99%.

Invece per stimare la sensibilità, che si traduce nella probabilità di “mancare” un vero sensitivo, bisogna avere una stima delle dimensioni dell’effetto cercato, ossia nel nostro esempio quanto il vero veggente azzecchi la previsione più di uno che tiri a indovinare. Per vedere quanto questo può essere critico, facciamo un esempio realistico, risparmiando i calcoli che comunque non sono troppo complicati. Nell’esperimento di lancio descritto sopra, decidiamo di stabilire la soglia del P-value allo 0,1% (vogliamo essere molto sicuri) e fare 30 lanci. Per passare il test non è necessario che il veggente indovini ogni volta, ma ne deve azzeccare almeno 23 su 30: la probabilità di fare meglio per caso è appunto meno dello 0,1%. D’altra parte ci aspettiamo che in assenza di particolari poteri ne indovini circa 15.

Adesso immaginiamo che arrivi un vero sensitivo, che però ogni tanto sbaglia; diciamo che sbaglia nel 20% dei casi, mentre chi tira a indovinare ovviamente sbaglia nel 50%. Con i numeri che abbiamo deciso, il calcolo ci dice che il sensitivo ha quasi il 40% di probabilità di non passare il test, ossia una sensibilità solo del 60%! Per ridurre questa probabilità si può aumentare il numero dei lanci (con 100 lanci la sensibilità arriva al 97% circa, che potrebbe essere accettabile), oppure abbassare la soglia, però ovviamente aumentando il rischio di avere un falso positivo. Ancora peggio va con un sensitivo che indovini solo un po’ più del caso: se indovina nel 60% dei casi, per portare il rischio di un falso negativo sotto il 10% senza cambiare la soglia bisogna arrivare a 500 lanci.

Questo trade-off tra sensibilità e specificità è una caratteristica di moltissimi protocolli sperimentali, e non solo dei semplici esperimenti binomiali come questo. In alcuni casi si può usare la forza bruta e per esempio aumentare banalmente il numero delle ripetizioni, ma in altri questo non è possibile e si deve cercare un compromesso.

Ci sono due conclusioni che si possono trarre da queste considerazioni: in primo luogo che non è il caso di mettere soglie inutilmente alte, ma soprattutto che è necessario sapere alcune cose sul fenomeno che si vuole mettere alla prova. Il fatto che la sensibilità possa essere stimata solo avendo un’idea delle capacità del sensitivo (o più in generale delle caratteristiche del fenomeno in esame) è all’origine del fatto che il CICAP organizza quasi esclusivamente esperimenti di “verifica” in cui si mette alla prova una specifica affermazione. Per esempio, nel caso del test di un sensitivo l’unico a poter dire quanto si aspetta di indovinare è il soggetto stesso, che non deve solo dirlo ma sottoscriverlo nel protocollo che si concorda prima del test. Se dice, come spesso capita, «indovinerò nel 99% dei casi» il problema non si pone e si può stare tranquilli che la sensibilità sarà sufficientemente alta; se però il suo potere non è un gran che («indovinerò nel 60% dei casi») probabilmente dovremo organizzare un test più lungo e complicato di quello che avremmo progettato sulla base della sola necessità di evitare i falsi positivi.