Il risultato di OPERA era “a sei sigma”, cioè statisticamente molto significativo: sarebbe stato estremamente improbabile ottenere per caso quel risultato se i neutrini avessero viaggiato rispettando il limite di velocità.

Facciamo una breve digressione per capire cosa significhi l’espressione “sei sigma”. Se avete letto la prima puntata di questa rubrica, ricorderete che il valore della probabilità di ottenere fortuitamente il risultato ottenuto in assenza del fenomeno cercato è un’indicazione della significatività statistica di un risultato sperimentale: più è bassa, più significativa è la misura. La probabilità è nota come P-value e non è, come si legge spesso, la probabilità di ottenere quel risultato per caso tout court, che generalmente è impossibile da calcolare. Un altro modo di esprimere più o meno la stessa cosa è dire quanto il risultato si discosta da quello che si sarebbe ottenuto in assenza del fenomeno. Questa “distanza” si misura in termini di sigma: senza entrare in dettagli che adesso non ci servono, è un parametro che indica quanto i valori che abbiamo misurato sono sparpagliati intorno al valor medio. Facendo alcune assunzioni approssimativamente vere nella maggior parte dei casi, si può tradurre le sigma in P-value usando la tabellina qui accanto.

P-value

1σ 0.32

2σ 0.045

3σ 0.0027

4σ 0.000063

5σ 0.00000057

6σ 0.0000000040

Cioè: se i neutrini avessero viaggiato alla velocità della luce e non di più, la probabilità di ottenere il valore misurato sarebbe stata minore di uno su 250 milioni.

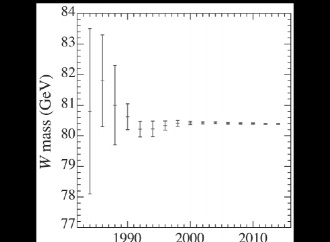

Gli stessi acceleratori del CERN che producono il fascio di neutrini per il Gran Sasso iniettano anche un fascio di protoni nel Large Hadron Collider, il più potente acceleratore di particelle mai costruito. I fasci di LHC sono usati da quattro grandi esperimenti per studi di ogni genere, tra cui la ricerca del bosone di Higgs, una particella prevista dalla teoria ma non ancora osservata sperimentalmente: l’ultima del “modello standard” a mancare ancora all’appello nonostante anni di ricerche.

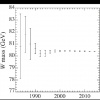

Il 13 dicembre 2011, poche settimane dopo l’annuncio di OPERA, nella stessa sala del CERN, i portavoce dei due più grandi esperimenti di LHC hanno fatto il punto sui dati raccolti nel 2011. Hanno annunciato alla sala strapiena di fisici che entrambi gli esperimenti vedevano indizi della presenza di una particella più o meno della stessa massa, grosso modo quella che molte teorie suggeriscono per lo sfuggente bosone. La significatività statistica della misura era però bassa: 2.5σ per ATLAS, 1.9σ per CMS, decisamente troppo poco per essere ragionevolmente certi che non si trattasse di una fluttuazione casuale dei molti fenomeni che possono “simulare” il bosone nel rivelatore.

Sia il risultato di OPERA sui neutrini sia quello sul bosone di Higgs, nelle parole stesse degli autori, richiedevano ulteriori studi e misure. Il primo perché inatteso e (almeno per i fisici) davvero sconvolgente, l’altro perché ancora troppo incerto; bisognava migliorare la significatività, ridurre l’incertezza statistica e scoprire finalmente il bosone mancante. Vediamo cosa è successo nei mesi seguenti.

Il 4 luglio 2012, dopo aver accumulato ancora centinaia di terabyte di dati, ATLAS e CMS hanno confermato in un seminario, se possibile ancora più affollato del precedente, che gli indizi di dicembre puntavano fortunatamente nella direzione giusta. Il bosone di Higgs è stato finalmente scoperto e ha una massa di circa 125 GeV, anche se per essere proprio rigorosi bisognerebbe dire che è stata scoperta una nuova particella con caratteristiche compatibili con quelle dell’Higgs. È ancora necessario controllare altre cose per essere sicuri che sia proprio lui, ma se fosse qualunque altra cosa sarebbe davvero sorprendente e inatteso. La significatività statistica era in questo caso di circa 5σ per entrambi gli esperimenti, il valore convenzionalmente ritenuto necessario per poter annunciare con certezza una scoperta.

Ma l’incertezza statistica non è l’unico tipo di errore da cui può essere affetta una misura. L’incertezza è in generale dovuta al fatto che gli strumenti di misura non sono perfetti, e introducono a ogni misura un errore, auspicabilmente piccolo. Se l’errore è casuale (qualche volta ottengo un valore un po’ più alto di quello reale, qualche volta un po’ più basso) l’incertezza è di tipo statistico e facendo la media di molte misure posso sperare di ridurla. In buona sostanza, quello che è successo a LHC.

Ma se l’errore introdotto va sempre nello stesso verso, per esempio perché la bilancia che uso è mal calibrata e aggiunge sempre un paio di grammi al peso misurato, si tratta di un errore del tipo chiamato sistematico, molto più ostico da scovare. In un esperimento di parapsicologia un trucco introduce un errore sistematico che non si può ridurre aumentando la statistica, ma solo migliorando il protocollo, cioè cambiando le condizioni. Oppure, nell’esempio della bilancia mal calibrata, per verificare se un risultato sia affetto da un errore sistematico si può provare a ripetere la misura con un’altra bilancia: strumenti diversi hanno errori sistematici diversi. È una delle ragioni dell’importanza della riproducibilità di cui abbiamo parlato qualche puntata fa. Se è vero per uno strumento semplice come la bilancia, a maggior ragione in esperimenti molto complessi si possono introdurre effetti sistematici difficili da scovare, ma se è possibile rifare l’esperimento con rivelatori e tecniche diverse ci si potrà mettere relativamente al sicuro. Per inciso, è la ragione per cui i grandi esperimenti a LHC sono due, il più indipendenti e diversi possibile.

Ma torniamo al Gran Sasso. Dopo l’annuncio di OPERA, i fisici si sono organizzati per provare a riprodurre il risultato: il CERN avrebbe fornito un fascio modificato per permettere una maggiore precisione nelle misure di velocità (la misura del tempo di volo non è lo scopo principale dell’esperimento) e questa volta tutti i rivelatori dei laboratori sotto la montagna, e non solo quello di OPERA, avrebbero osservato il fascio e provato a misurare la velocità dei neutrini. Nel frattempo, però, era stato individuato un problema in una connessione in fibra ottica nell’elettronica di OPERA che avrebbe potuto causare un effetto proprio simile a quello osservato nella misura del tempo di volo delle particelle tra il CERN e il Gran Sasso. E infatti il risultato della nuova misura è stato quello che molti si aspettavano fin dal principio: tutti i rivelatori, incluso quello di OPERA aggiustato, osservarono neutrini ligi alla legge che non viaggiavano più veloci della luce. Peccato.

I fisici di OPERA sono stati fortunati (se pure forse un po’ precipitosi nell’annunciare il risultato) perché sono riusciti a scovare l’origine dell’errore sistematico. In molti casi, specie se l’esperimento è complesso, non è così semplice e succede che un risultato statisticamente significativo e in apparenza solido non riesca a essere riprodotto senza che si capisca il perché. Cosa sarebbe successo se il connettore difettoso non fosse stato trovato? Il risultato di OPERA sarebbe rimasto nella storia della fisica come una anomalia non spiegata, al pari di molte altre. E magari avrebbe continuato a circolare sul web, additato da alcuni come un mystero insabbiato dalla scienza ufficiale perché contrario ai “dogmi”, o una prova del fatto che in realtà non sappiamo ancora tutto dell’universo. Come se ce ne fosse bisogno.