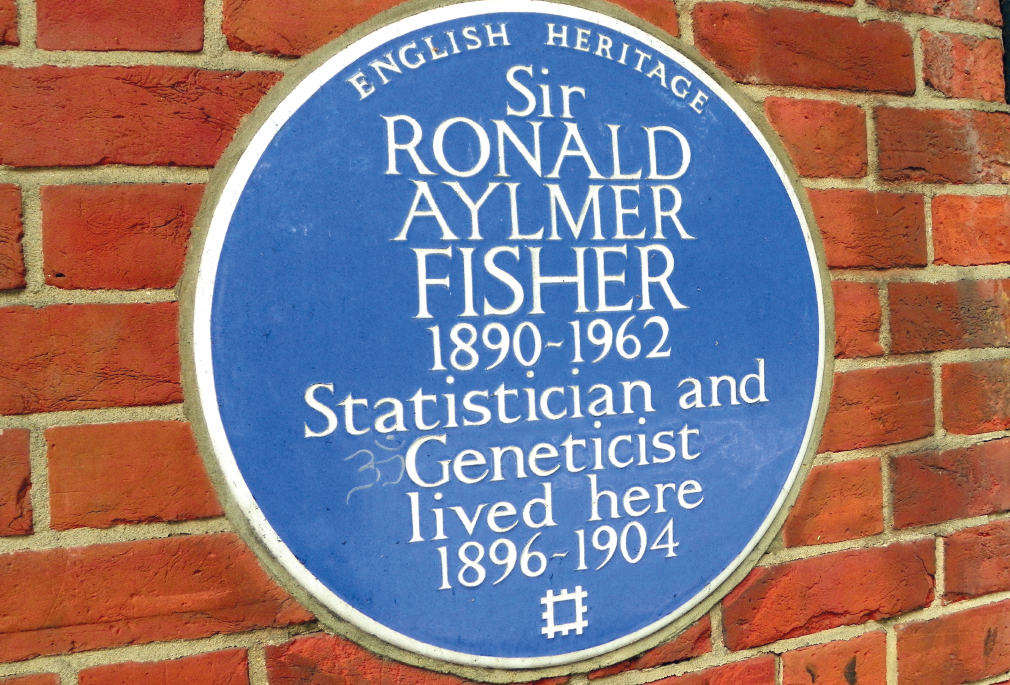

Il “test di significatività” è stato introdotto nella metodologia scientifica da Ronald Fisher nel 1925[3]: esso consente di «controllare se i dati raccolti sono o non sono in accordo con qualsiasi ipotesi che venga avanzata». Consideriamo un esempio tratto a caso, appunto da Google Scholar: «i bambini allergici mostravano una conta di microrganismi aerobici più alta (P < 0.05)»[4]. Questa frase significa in pratica: «Nel confronto della conta di microrganismi aerobici fra bambini non-allergici e allergici, questi ultimi hanno mostrato una conta così alta che, se la differenza fosse dovuta al caso, si sarebbe verificata con probabilità minore del 5%». Un bel risparmio di parole (qualunque cosa significhi la conta di microrganismi aerobici nei bambini): che cosa c’è dunque che non va?

La critica principale che viene mossa oggi all’approccio basato sul p-value è di ordine pratico: la procedura è meno intuitiva di quanto possa sembrare a prima vista, e induce in errori di interpretazione anche ricercatori esperti. Il ragionamento si avvale di una logica per contraddizione: si calcola quanto i risultati siano inverosimili sotto “l’ipotesi nulla”, la quale asserisce che qualunque discrepanza si riscontri nel confronto di interesse è un puro effetto del caso, e che rappresenta quindi il contrario (l’uomo di paglia, secondo alcuni critici) dell’ipotesi che è invece il vero interesse dei ricercatori; se quindi il p-value si rivela sufficientemente piccolo, il che accade se quei risultati sono altamente improbabili ammettendo vera l’ipotesi nulla (ma in effetti la si vorrebbe falsificare), questa si può rigettare, e i ricercatori ne ricavano l’indicazione che la loro ipotesi è fondata perché l’ipotesi nulla è falsificata “a quel (dato) livello di significatività”.

Fa venire il mal di testa... E a volte i ricercatori si sbagliano: sottopongono al test la loro ipotesi di lavoro, e se i dati risultano compatibili con essa (il p-value è “non significativo”), ne ricavano l’indicazione che quell’ipotesi è ben supportata. Questa è una delle fallacie indicate come comuni nella letteratura scientifica; un altro errore molto diffuso è ritenere che il p-value sia la probabilità di commettere un errore cosiddetto del primo tipo (assumere per vera una falsità); altre fallacie sono connesse all’interpretazione del p-value come di una probabilità che si riferisce alle ipotesi piuttosto che (come dev’essere) ai dati, ad esempio che il p-value sia la probabilità che l’ipotesi nulla sia vera, o che un p-value non significativo indichi che l’ipotesi nulla sia vera. Ancora altri fraintendimenti sono connessi alla confusione fra la significatività statistica (misurata dal p-value) e l’entità dell’effetto osservato, ovvero la sua significatività scientifica.

Ci si può chiedere come sia possibile che tanta confusione regni sotto il cielo, considerando anche che il test di significatività, nella sua formulazione originaria, non è altro che la formalizzazione matematico-statistica di un procedimento mentale che applichiamo tutti nella vita quotidiana.

Supponiamo di aver ordinato una pizza a domicilio al nostro solito fornitore, che in genere ce la consegna in circa 20 minuti. Questa volta però passano 30 minuti e la pizza non arriva: quanto altro tempo deve passare perché decidiamo che è successo qualcosa e richiamiamo il pizzaiolo? L’ipotesi di fondo (“l’ipotesi nulla”) è che tutto è regolare, e il ritardo è frutto del caso. Ma se passano 40 minuti è ovvio che il ritardo è anomalo: le congetture che possiamo figurarci come possibili cause sono molte, ma comunque l’ipotesi che il ritardo sia normale non regge, e quindi ritelefoniamo. Il p-value è in questo caso la probabilità che in condizioni normali la pizza ci venga consegnata 40 minuti o più dopo il nostro ordine; noi nel quotidiano ne diamo una valutazione intuitiva, mentre il compito della statistica è di darne una misura numerica il più possibile precisa.

Sembra sensato: se noi abbiamo un’idea di come funzionano le cose in una certa situazione, ci aspettiamo che le nostre esperienze siano compatibili con quell’idea; ma se verifichiamo che esse non lo sono, dovremo decidere se l’inconsistenza supera una certa soglia critica, e, se la supera, saremo indotti a scartare quell’idea come falsa. Nel contesto scientifico: se i dati sono troppo improbabili sotto l’ipotesi nulla, che rappresenta lo stato attuale della conoscenza, i ricercatori sono autorizzati a confutarla e a cercare nuove vie che possano riconciliare i dati con la realtà, modificando la teoria corrente o proponendone una nuova. Anche nel contesto delle tematiche del CICAP: l’onere della prova spetta a chi pretende di cambiare lo stato della conoscenza attuale, includendovi come tecnica efficace qualche pratica paranormale, ad es. la rabdomanzia; l’ipotesi nulla è dunque che i rabdomanti indovinino a caso, ma se il p-value di una serie di prove controllate risultasse sufficientemente piccolo, ne ricaveremmo un’indicazione che la rabdomanzia funziona davvero (finora però nessun rabdomante ha superato un test controllato e, peraltro, nessuno è riuscito ad incassare il famoso milione di dollari messo in palio dalla James Randi Educational Foundation[5]).

E tuttavia proprio questo schema è considerato lacunoso da molti studiosi di formazione matematica. Una linea di pensiero concettuale, che sottende buona parte delle critiche di ordine teorico all’uso del p-value, sostiene che esso non sia una misura appropriata della forza dell’evidenza contenuta nei dati sperimentali.

È certamente vero che il test di significatività non fornisce, in quanto tale, dei criteri precisi sul rifiuto o il non-rifiuto dell’ipotesi nulla. Fisher stesso affermò che un p-value minore di 0,05 può essere considerato ragionevole nella prassi scientifica per rifiutare l'ipotesi nulla, ma sostenne sempre che il significato scientifico di un certo valore di significatività statistica debba essere valutato caso per caso. Questo apparve come una grossa carenza ai due matematici Jerzy Neyman e Egon Pearson, contemporanei di Fisher, che pertanto si dedicarono a costruire una metodologia che la colmasse. In breve, la tesi centrale dell’approccio di Neyman e Pearson è che il test delle ipotesi deve avere come obiettivo finale la scelta fra due ipotesi contrapposte, che siano esaustive e mutuamente esclusive: da una parte l’ipotesi nulla, dall’altra una ben formulata ipotesi alternativa. Se si rifiuta l’ipotesi nulla si accetta quella alternativa e viceversa, e una volta effettuata la scelta non ci si ritorna sopra. Questo approccio implica che debba essere definita una soglia a priori di p-value che determini la scelta, soglia “critica” che Neyman e Pearson chiamarono "alfa": se il p-value calcolato in una data situazione risulta minore di alfa, l’ipotesi nulla viene rigettata, altrimenti viene accettata. Da qui discese la definizione dell’errore del I tipo (rifiutare l’ipotesi nulla quando è vera) e dell’errore del II tipo (accettare l’ipotesi nulla quando è falsa). Il problema teorico era quindi, per loro, di ridurre le conseguenze dei due tipi di errore: poiché minimizzare la probabilità di un errore significa inevitabilmente aumentare la probabilità dell’altro, si tratta di stabilire, situazione per situazione, qual è il compromesso meno dannoso. In questo senso, l’approccio di Neyman e Pearson è più una teoria sulla decisione che una teoria sulla crescita della conoscenza (come è invece l’approccio di Fisher).

I due paradigmi, di Fisher da un lato e di Neyman e Pearson dell’altro, sono epistemologicamente diversi, tanto che molti autori li considerano incompatibili. Sono ambedue basati sul calcolo del p-value; ma mentre nel test di significatività di Fisher il p-value è l’obiettivo finale dell’analisi statistica, nel test delle ipotesi di Neyman e Pearson il p-value (che nei calcoli può anche rimanere implicito) è solo un mezzo per arrivare a una decisione sull’accettazione dell’una o dell’altra ipotesi in competizione. Tuttavia, i libri di testo di statistica, particolarmente nelle scienze biomediche e sociali, presentano la materia come una singola e unificata metodologia di inferenza statistica, quando nei fatti si tratta di un ibrido anonimo (postbellico) sottilmente inconsistente, in cui si cerca di bilanciare da una parte l’ovvia inapplicabilità nella pratica scientifica della scelta rigida fra due ipotesi contrapposte precostituite (Neyman-Pearson), dall’altra la soggettività inerente alla scelta di un particolare livello di significatività come potenzialmente falsificante di una data ipotesi (Fisher). E non è sorprendente che da tale confusione teorica nascano nella pratica una gran quantità di malintesi.

Il problema posto oggi fortemente da una parte della comunità dei matematici-statistici è se sia il caso di eliminare del tutto il p-value dalla letteratura biomedica. Il libro di Deborah Mayo[6] L’inferenza statistica come test severo: al di là delle guerre della statistica (purtroppo non tradotto in italiano) è un saggio sorprendentemente ben leggibile dato l’argomento, ed è un testo fortemente consigliato a chi voglia capire il senso di una diatriba che è arrivata ormai anche agli organi di informazione rivolti al grande pubblico[7].