Studiando il moto delle goccioline attraverso un microscopio appositamente costruito, Millikan fu in grado per la prima volta di misurare la carica dell’elettrone, scoperto da J. J. Thomson nel 1897 (una quantità nota come e). Il risultato di un primo gruppo di misure fu pubblicato sulla Physical Review nel 1911; Millikan trascorse l’anno successivo a perfezionare la tecnica e pubblicò una nuova misura, più precisa, nel 1913: il nuovo valore si discosta da quello attualmente accettato per meno del 2%.

L’esperimento di Millikan è un interessante pezzo di storia della fisica per molte ragioni, oltre naturalmente all’importanza della misura. Per cominciare, è ancora studiato dagli studenti del primo anno di Fisica ed è stato votato, in un sondaggio fatto nel 2002 dalla rivista Physics World, il terzo più bell’esperimento di fisica di tutti i tempi. (Per i curiosi, il vincitore è stato l’esperimento della doppia fenditura di Davisson e Germer, secondi classificati gli esperimenti di Galileo sulla caduta dei gravi.)

Poi, dalla fine degli anni '70, il lavoro di Millikan è stato oggetto di una revisione critica. Rileggendo i logbooks degli esperimenti, conservati al California Institute of Technology, Allan D. Franklin notò che, a differenza di quanto Millikan aveva affermato nell’articolo del 1913, non tutte le misure fatte erano state usate per calcolare il valore finale: di 107 gocce osservate, solo 58 furono pubblicate e contribuirono alla misura finale del valore di e. Per alcune di queste sono riportate buone ragioni per l’esclusione (malfunzionamenti dell’apparato, per esempio), ma alcune sono state escluse senza una ragione evidente. Insomma, apparentemente Millikan aveva “massaggiato” i dati per ottenere un risultato migliore: un esempio di una delle pratiche scientifiche discutibili di cui abbiamo parlato molte volte.

In realtà, se si rifanno i calcoli per tenere conto anche degli eventi esclusi il valore di e cambia davvero poco, anche se l’errore aumenta un po’. La storia della fisica non sarebbe cambiata. O magari Millikan aveva delle ottime ragioni per escludere i punti, e semplicemente non le ha scritte sul logbook. Il dibattito sui peccati di Millikan è ancora aperto, ma concentriamoci su un altro aspetto: sono passati ormai più di cento anni dagli esperimenti e siamo ancora in grado di controllare i calcoli perché tutti i dati erano semplicemente scritti su carta, e i taccuini sono stati conservati. Cosa sarebbe successo se, come accade oggi, i dati fossero stati conservati su un disco rigido, o su nastri magnetici che hanno bisogno di un lettore compatibile e funzionante?

Facciamo un passo indietro. In un articolo scientifico sono descritti i metodi e i risultati di una ricerca, ma generalmente non sono riportati per intero i dati utilizzati; nella gran maggioranza dei casi sarebbe impossibile. Ma ci sono molte ottime ragioni per conservare questi dati anche dopo la pubblicazione dei risultati in modo da renderli accessibili ai ricercatori futuri.

Una ragione ovvia è che molto spesso produrre i dati di un esperimento scientifico è straordinariamente costoso (come nel caso dei grandi esperimenti del CERN, per esempio); nel caso delle scienze osservative, poi, riprodurli può essere semplicemente impossibile. Se domani osservassimo un’esplosione di supernova nella nostra galassia chissà quanto tempo dovremmo aspettare per la prossima, dato che l’ultima è stata osservata nel 1604. L’altra ragione ovvia è garantire la possibilità di ricontrollare tutte le fasi di una ricerca, o verificare di nuovo i risultati come nel caso di Millikan, per studiare la storia della scienza o per qualunque altro scopo.

Ma ci sono ragioni meno ovvie e più interessanti. Per esempio, potremmo voler riesaminare dei dati alla luce di qualche nuova conoscenza per cercare qualcosa che all’epoca non era stata cercata, oppure usare nuovi strumenti per estrarre ancora più scienza dagli stessi dati. La potenza di calcolo a disposizione dei ricercatori oggi, magari unita a nuove tecnologie come l’intelligenza artificiale, permette analisi impensabili anche solo dieci anni fa.

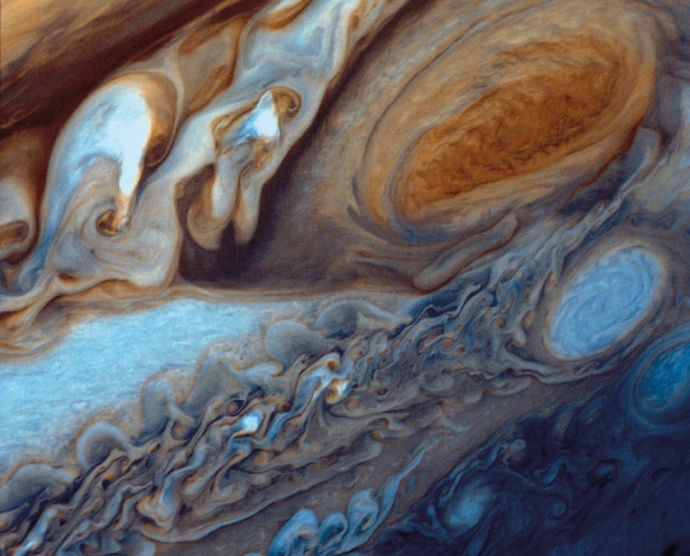

Per esempio, nel 2017 un gruppo di ricercatori dell’Università del Colorado a Boulder, guidato dall’astronoma Fran Bavenal, ha riesaminato i dati raccolti nel 1979 dalle due sonde Voyager, nel passaggio vicino a Giove. Alla luce di modelli teorici non disponibili allora, dati vecchi di quasi trent’anni sono serviti per migliorare la nostra conoscenza della magnetosfera di Giove.

A volte invece è proprio la natura storica dei dati a essere interessante. Lo strato di ozono nella stratosfera ha un ruolo fondamentale nello schermare i raggi ultravioletti della luce solare; ricostruire la storia della sua concentrazione atmosferica è importante, per esempio, per capire quanto la sua riduzione abbia origine antropica o sia anche l’effetto di qualche processo naturale.

L’astronoma inglese Elizabeth Griffin ha provato per la prima volta a misurare la concentrazione dell’ozono atmosferico usando spettroscopie astronomiche raccolte all’osservatorio di Mount Wilson, in California, tra il 1935 e il 1942. Lo spettro di una sorgente luminosa dipende sia dalla composizione chimica della sorgente (in questo caso stelle osservate attraverso un telescopio) sia da quella dei gas attraversati dalla luce prima di raggiungere l’osservatore, che assorbiranno in modo diverso lunghezze d’onda diverse. È perciò possibile estrarre dallo spettro osservato informazioni sull’ozono incontrato dalla luce nell’attraversare l’atmosfera, come ha dimostrato Griffin nell’articolo pubblicato nel 2006 su Atmospheric Chemistry and Physics.

Le cose però non sono così semplici: non sempre basta conservare qualche quaderno, come quelli di Millikan, per poterli usare (magari con qualche attenzione: i taccuini di Marie Curie sono ancora fortemente radioattivi per la contaminazione da radio e polonio, e possono essere consultati solo indossando indumenti protettivi).

Tralasciando per ora i problemi di interpretazione di dati presi in contesti storici e culturali diversi, esistono diversi problemi pratici.

Un primo esempio riguarda i metadati, ossia informazioni che descrivono i dati stessi. La posizione di una stella nel cielo è relativamente poco importante se le osservazioni spettroscopiche servono per studiare la stella stessa, ma è cruciale se vogliamo usare i dati per lo studio dell’atmosfera. Se la stella è bassa sull’orizzonte lo spessore di atmosfera attraversato è molto maggiore rispetto a una stella vicina allo zenit e i dati andranno “normalizzati” in modo diverso. A volte gli astronomi dell’epoca non avevano registrato questa informazione, rendendo quella particolare lastra inutilizzabile per lo studio dell’ozono atmosferico. È quindi importante conservare anche i metadati (in questo caso l’altezza della stella sull’orizzonte al momento della misura), e una difficoltà ulteriore può essere che, al momento della misura, nessuno abbia pensato a registrare qualche informazione all’epoca ritenuta irrilevante. Griffin ha fatto più fatica a recuperare le schede e i registri con la descrizione del contenuto delle lastre, a volte su fotocopie di fotocopie, che le lastre stesse.

Un’altra difficoltà risiede nel formato e nel supporto fisico su cui i dati sono conservati. Le lastre fotografiche degli anni Trenta, per quanto ben conservate, sono un supporto obsoleto e vanno digitalizzate per poter essere usate con le attuali tecniche di analisi computerizzata. Nell’epoca di transizione tra l’analisi completamente manuale delle lastre e i moderni sensori elettronici che restituiscono i risultati già in forma digitale, venivano prodotti “microdensitometri” specialmente progettati per digitalizzare le spettrografie, in cui la precisione nella misura dell’intensità luminosa è più importante della risoluzione spaziale, contrariamente a quanto accade con gli scanner commerciali.

Griffin ha recuperato uno degli ultimi strumenti ancora funzionanti, ma il problema è evidente: non è sufficiente conservare i dati e i metadati, ma serve anche conservare gli strumenti necessari per poterli leggere. I nastri magnetici su cui si conservavano i dati si sono evoluti dalle bobine aperte usate fino agli anni Ottanta alle cassette di varie forme e capacità usate ancora adesso: Wikipedia elenca più di 50 diversi formati introdotti (e in gran parte ormai obsoleti) a partire dalla metà del Novecento. Va da sé che i dati devono essere periodicamente copiati sui nuovi formati, o saranno persi quando l’ultimo lettore cesserà di funzionare.

Ma ancora non basta. Quando Bavenal e collaboratori hanno recuperato i dati del Voyager, hanno dovuto anche aggiornare il software scritto negli anni Settanta per computer molto diversi da quelli di oggi. Allo stesso modo, poter leggere i dati degli esperimenti del CERN di oggi richiede l’uso di librerie di software estremamente complesse, che quindi devono essere conservate insieme ai dati e alla documentazione necessaria per usarle. E anche in questo caso il supporto fisico è importante: i programmi usati in molti esperimenti di fisica fino agli anni '70, registrati su schede perforate, sono ormai persi per sempre.

Non basta perciò conservare i dati, facendo attenzione che i supporti su cui sono conservati non diventino illeggibili; bisogna anche mettere i ricercatori del futuro nelle condizioni di poterli usare. È necessario conservare i metadati e la documentazione che li descrivono, il software necessario per leggerli e analizzarli, insomma incapsulare in qualche modo tutto quello che potrebbe servire.

Sia la comunità scientifica (che si rende conto di quanta scienza potreb be ancora esserci nei dati) sia gli enti finanziatori (che investono un sacco di soldi nella produzione dei dati e sono quindi interessati a spremerli fino all’ultima goccia) si stanno dando da fare per proporre soluzioni per lo scambio e la conservazione dei dati: ne parleremo la prossima volta.